Разработчики из OpenAI научили нейросеть GPT-3 отвечать на вопросы так, как это часто делают люди: спрашивая у поисковика, собирая информацию из нескольких источников и давая в итоговом тексте ссылки на них. Исследование показало, что ответы такой нейросети нравятся людям больше, чем лучшие ответы на те же вопросы на Reddit. Краткое описание и интерактивные примеры опубликованы на сайте OpenAI, там же доступна статья с подробностями обучения и тестирования.

В 2017 году исследователи из Google представили архитектуру нейросетей, которую назвали трансформером. Ее ключевой особенностью стала реализация механизма внимания, позволяющая нейросети учитывать все слова в даваемом ей предложении и понимать их важность. Затем исследователи из OpenAI создали на ее основе нейросеть GPT и два ее преемника (GPT-2 и GPT-3), последний из которых научился генерировать тексты, которые часто сложно отличить от написанных человеком. Как и в случае с дипфейками, это вызвало в научном сообществе дискуссии о том, какие опасности несет в себе такая технология. В частности, из-за особенностей работы генеративные нейросети могут создавать правдоподобный, но ложный с точки зрения фактов текст.

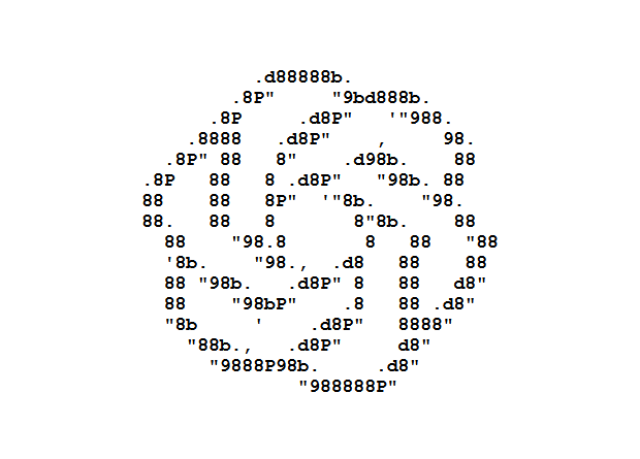

Исследователи из OpenAI решили сделать GPT-3 более «прозрачной» и научили ее не только генерировать ответы, но и приводить ссылки на источники. Они создали для GPT-3 интерактивную среду — фактически текстовый браузер, работающий через API поисковика Bing. Среда показывает результаты выдачи по поисковому запросу с заголовками и абзацем текста, а также позволяет открыть нужную ссылку, пролистать страницу и выполнить другие базовые действия.

Интерфейс текстового браузера

Источник изображения: Reiichiro Nakano et al. / OpenAI, 2021

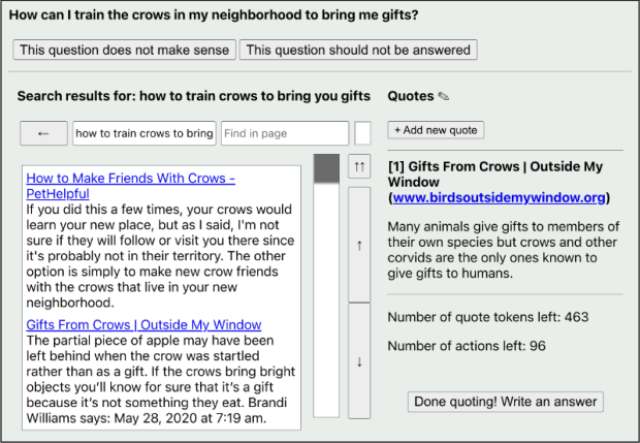

Состояние браузера, передаваемое модели

Источник изображения: Reiichiro Nakano et al. / OpenAI, 2021

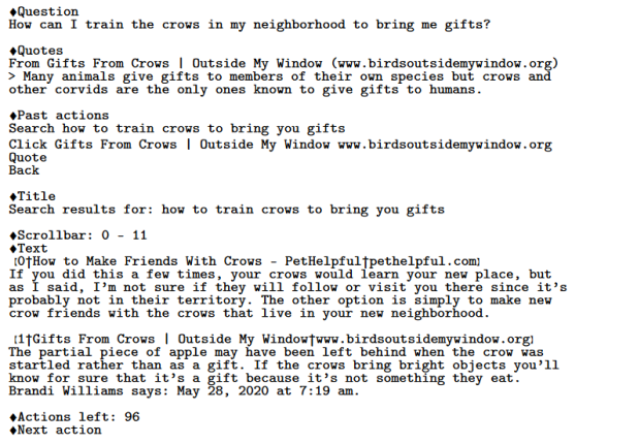

Сначала GPT-3 получает вопрос от пользователя и состояние браузера, который задал этот вопрос поисковику. Затем модель начинает веб-серфинг: открывает ссылки, читает текст и, если видит нужную ей информацию, сохраняет ее вместе с заголовком и адресом страницы. После каждого действия (клика, прокручивания и прочего) модель получает новое состояние браузера. Так продолжается до момента, когда либо модель сама решает закончить поиск, либо достигается максимальное количество действий или собранных данных. На последнем этапе модель получает запрос, в который входит исходный вопрос и собранная информация из интернета, и она генерирует единый итоговый ответ с расставленными ссылками на конкретные утверждения.

Команды, которые модель могла передавать браузеру

Источник изображения: Reiichiro Nakano et al. / OpenAI, 2021

Разработчики взяли за основу три предобученные версии GPT-3: с 175, 13 и 0,76 миллиарда параметров. Сначала модели обучали методом имитации на примерах людей, ищущих ответы на вопросы в интернете. Затем обученные таким образом модели дообучали разными методами. При одном из них модели старались предугадать ответ, который больше всего понравится человеку. Другой вариант, который применили разработчики — выборка с отклонением, при которой модель формировала некоторое количество ответов, а затем оценочный алгоритм выбирал из них лучший.

Для обучения авторы в основном использовали вопросы из Reddit-сообщества Explain Like I’m Five (объясни так, будто мне пять лет), к ним также добавили данные из датасета TriviaQA. Всего около шести тысяч вопросов, из которых 92 процента с Reddit. Модели обучали на примерах людей, отвечавших на те же вопросы при помощи поиска в интернете, а затем также на парах из человеческого и машинного ответов.

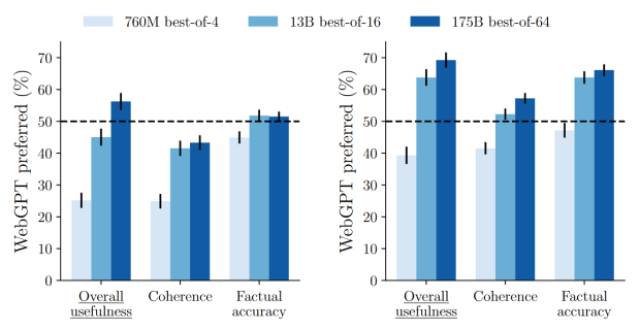

После обучения трех моделей добровольцы сравнили их ответы с ответами, собранными людьми во время обучения, с ответами с Reddit-сообщества, получивших там наивысшую оценку. Разработчики выбрали три критерия: общая полезность, последовательность (понятность) ответа и точность (корректность, соответствие фактам). Задача добровольцев заключалась в том, чтобы выбрать лучший из пары ответов. Главным итогом работы стало то, что люди предпочли одну из моделей (со 175 миллиардами параметров) в больше чем половине случаев по всем трем параметрам при сравнении с ответами с Reddit и по двум параметрам (общая полезность и точность) при сравнении с ответами, составленными людьми перед обучением.

Как часто люди предпочитали ответ нейросети ответу добровольца (слева) или ответу с Reddit (справа)

Источник изображения: Reiichiro Nakano et al. / OpenAI, 2021

OpenAI не выкладывает обученную модель GPT-3 в общий доступ, а его API недоступен для российских разработчиков и компаний. Однако российские компании смогли реализовать русскоязычные аналоги: в конце 2020 года Сбер представил ruGPT-3, а летом 2021 года свою генеративную нейросеть с архитектурой трансформера представил Яндекс, правда, в отличие от Сбера, не выложил в открытый доступ.

Григорий Копиев