Использование искусственного интеллекта военными при принятии решения о нанесении ядерного удара представляет серьезную опасность, пишет бывший замминистра обороны США Роберт Уорк в статье, опубликованной изданием Breaking Defense.

Уорк отметил, что системы искусственного интеллекта запускаются по определенным параметрам и показателям и в некоторых ситуациях ИИ может расценить неопасные факторы как представляющие угрозу, что это является "тревожной перспективой", передает РИА "Новости".

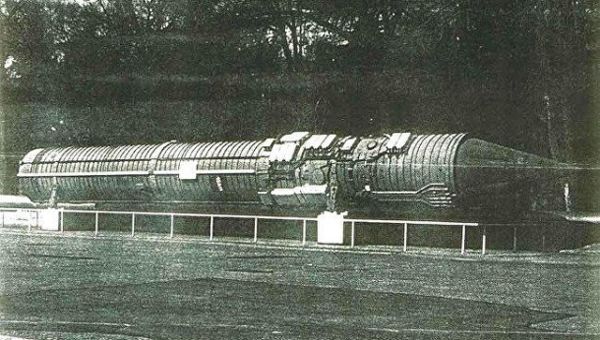

Бывший заместитель шефа Пентагона привел в пример российскую систему "Периметр", которая якобы может принять сейсмическую активность за ядерные взрывы. По его словам, "Периметр" в таком случае направит запрос в штаб войск, и, если вдруг не получит ответа, может отдать команду на запуск межконтинентальных баллистических ракет.

Уорк считает, что использование искусственного интеллекта в военной сфере может обернуться плачевным последствиям и без его прямого участия в управлении ядерным оружием. Опасным также является его использование при анализе разведывательных данных, а также в системах раннего предупреждения, указал он.

Например, система искусственного интеллекта в командном центре Китая, проанализировав оперативные данные, может прийти к выводу, что Соединенные Штаты готовятся нанести удар по Китаю, и порекомендуют нанести превентивный удар, пишет Уорк.

Эксперт в то же время признает, что искусственный интеллект может принести пользу военным. Он призывает применять его ограниченно и не распространять на ядерное вооружение, поскольку это может привести к "катастрофическому сценарию".

Ранее западные СМИ назвали четыре основные причины возможной гибели человечества.

Ольга Никитина