Искусственный интеллект предлагает человечеству сыграть в русскую рулетку

Машины считают и действуют, если им позволяют, гораздо быстрее людей. Многие аналитики говорят, что глобальные компьютерные сети приводят к появлению "быстрого мира", в котором человек будет самым медленным, ненадежным и уязвимым звеном. Это показывает эволюция бирж, в которых интернет-брокеры вытеснили людей.

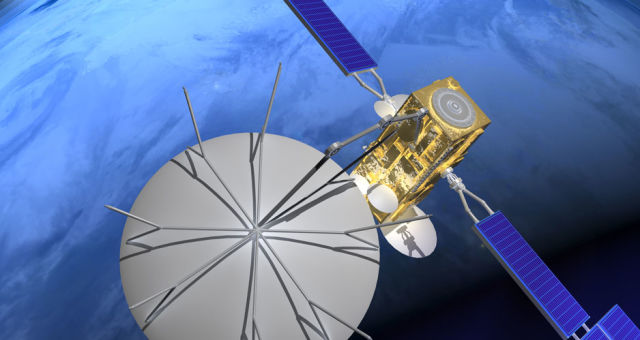

Активно развивается космический интернет, который позволит реагировать на происходящее еще быстрее и даст широкополосный доступ в Сеть из любой точки Земли. Спутниковые системы HughesNet и ViaSat находятся на геостационарной орбите (35 тыс. км, задержка – 600 мс), навигационные системы GPS, ГЛОНАСС и Galileo используют среднюю околоземную орбиту (выше 2000 км, задержка – 140 мс). Спутники Starlink и OneWeb ориентируются на орбиты 335–346 километров, а также на сетевые технологии. Речь идет о десятках тысяч новых спутников и уменьшении задержки до 10 миллисекунд. Этот уровень достаточен для управления беспилотными автомобилями и многими другими техническими системами с использованием космического сегмента (а также для ряда других приложений). Человек реагирует на происходящее примерно в сто, а то и в тысячу раз медленнее.

Естественно, появляется соблазн использовать возможности, возникающие в цифровой реальности, в военной сфере. В настоящее время в мире насчитывается примерно 14,5 тысячи ядерных зарядов, из которых около 9500 на боевом дежурстве. За 70 с лишним лет ядерной эры не было ни одного несанкционированного случая применения ядерного оружия. В литературе описано множество нештатных ситуаций со стратегическими ядерными силами (СЯС), которые тем не менее не привели к катастрофе. Прежде всего это связано с мудростью, осторожностью и здравым смыслом людей в контуре управления СЯС.

“ Масштабный ядерный конфликт – типичный "Черный лебедь". Надеяться на адекватность моделей не приходится ”

Однако в настоящее время мы видим другую тенденцию, направленную в конце концов на вытеснение человека из этого контура. В самом деле сейчас после информации о ракетном нападении у политических руководителей остается около 45 минут на принятие решения об ответном ударе. После выхода США из Договора о ракетах средней и малой дальности это время сократится впятеро. Перспективные системы оружия еще более его уменьшат. В конце концов в "быстром мире" на информацию о нападении будут реагировать машины.

При этом возникает опасная иллюзия, что машины лучше нас во всем разберутся, либо соблазн за счет более совершенных систем искусственного интеллекта (AI) нанести упреждающий удар, не получив ответного. "AI меняет главную парадигму ядерного сдерживания. В ситуации, когда у вас и у меня хватает оружия, чтобы уничтожить друг друга десять тысяч раз, становится понятно, что соревноваться в дальнейшем совершенствовании этого оружия бессмысленно. Все системы управления сейчас переключаются понемножку на то, что называется AI против AI, потому что он быстрее. Если, как Путин говорил, будет у них две минуты на подлетное время, то за две минуты можно очень много проанализировать и понять, что это – нападение, или отвлекающий маневр, или ошибка. Более того, на что полагались со времен Карибского кризиса – это так называемый прямой телефон, где очень быстро успевают переговорить двое. А с AI они успеют переговорить, допустим, шестьдесят миллионов раз. Задать друг другу два миллиарда уточняющих вопросов и получить два миллиарда уточняющих ответов. Короче, система принятия решений неотвратимо переходит на то, что мы называем AI… Есть вещи, которые не имеют корректного решения, но все равно будут сделаны. Так же и передача управления штабов командования, оценка ситуации и принятия последних решений уже сейчас потихоньку передаются на уровень AI и в грядущие годы будут полностью туда выведены. С точки зрения доктрины взаимного уничтожения ничего нового. Изменения произойдут в области психологии. Если мы считаем, что наш искусственный интеллект мощнее, ударим. В результате скорее всего конец мира будет столь же ужасен, как без искусственных интеллектов", – говорит один из ведущих экспертов в этой области Сергей Карелов. Трудно согласиться с последним утверждением, и мы к нему еще вернемся.

Нынешнюю ситуацию и связанный с ней риск ("Черный лебедь" в терминологии Нассима Талеба) предвидел и описал польский фантаст и футуролог Станислав Лем. Поэтому меры, направленные на то, чтобы предотвратить передачу "последних решений" на уровень машин, можно назвать барьером Лема. В 80-х годах писатель опубликовал шутливое эссе – воспоминания историка из далекого будущего о развитии систем вооружений XXI века. Текст оказался во многих отношениях пророческим. Процитируем фрагмент: "Научно-технический прогресс был чреват парадоксом особого рода: чем более совершенные порождал он виды оружия, тем в большей степени эффективность их применения зависела от случайности, не поддающейся точному расчету… Появляющиеся одна за другой новые системы оружия характеризовались возрастающим быстродействием, начиная с принятия решений (атаковать или не атаковать, где, каким образом, с какой степенью риска, какие силы оставить в резерве и т. д.), и именно это возрастающее быстродействие снова вводило в игру фактор случайности, который принципиально не поддается расчету. Это можно выразить так: системы неслыханно быстрые ошибаются неслыханно быстро".

“ "Звездные войны" были свернуты, потому что отладка программы требовала миллионов человеко-лет работы опытных программистов ”

Разница между осознанно принятым руководителем решением и игрой в русскую рулетку принципиальна. История в целом и Карибский кризис в частности показывают, что в первом случае шансы уцелеть у большей части человечества гораздо выше. Однако для этого у руководителей должна быть возможность принять решение. В "быстром времени" после барьера Лема мы окажемся заложниками искусственного интеллекта, наших компьютеров, программ и алгоритмов и шансов у нас не останется…

Ситуацию усугубляет несколько обстоятельств. Во-первых, модели, алгоритмы и программы описывают явления, процессы, системы, которые мы представляем. Они ориентированы, как правило, на то, что уже происходило или происходит. Масштабный ядерный конфликт – вещь невиданная, типичный "Черный лебедь". Поэтому надеяться на адекватность моделей или на то, что "наш AI сильнее", не приходится.

Во-вторых, еще со времен Сунь-Цзы и Клаузевица понятно, что война – область неопределенного. И военные, и спецслужбы постоянно заняты подготовкой сюрпризов, неожиданностей для противника. Поэтому блестящая игра компьютеров в шахматы и в го, где правила четко установлены и набор фигур фиксирован, не должны вводить нас в заблуждение. В реальном конфликте на доске могут появиться совсем другие фигуры и использоваться парадоксальные стратегии. Достаточно вспомнить про "мягкую силу", "оранжевые революции", кибервойны, "Троянского коня" и т. д. Главными факторами могут оказаться совсем не те, которые считались таковыми при планировании в Генеральных штабах. Это прекрасно иллюстрирует опыт и Первой, и Второй мировых войн.

В-третьих, пока не удается создавать программы, в которых ошибок гораздо меньше, чем одна на тысячу команд. По оценке экспертов, в операционной системе Windows около 50 тысяч уязвимостей и масса "недекларируемых возможностей". "Звездные войны" были свернуты во времена Рейгана, потому что отладка программы потребовала миллионов человеко-лет работы квалифицированных программистов. С тех пор ничего существенно не изменилось к лучшему.

В-четвертых, никто не отменял "проклятие размерности". В автомобиле около 10 тысяч деталей, в самолете – около 100 тысяч. Но даже для сотни объектов число способов связать их превышает количество атомов во Вселенной. Поэтому не стоит слишком полагаться на возможности компьютеров, и остается лишь удивляться и радоваться тому, что машины ездят, а самолеты летают.

Кроме того, опыт Фукусимы, "Челленджера", Чернобыля, "Титаника", катастроф на морских буровых платформах показывает, что надежность сложных технических систем, в повышение которой были вложены огромные усилия, оказалась совсем не так велика, как предполагали. В нашем случае цена подобной ошибки несопоставимо выше.

Вывод один: "последние решения" не могут приниматься компьютерами в "быстром времени". Нашей цивилизации нельзя преодолеть барьер Лема. Поэтому надо садиться и договариваться о пределах использования AI в военных системах. Важно было бы сделать это сейчас, до ближайшего большого военного конфликта. Это повысит шансы на то, что он не будет последним…

Заголовок газетной версии – "Быстрый мир" и барьер Лема".

Георгий Малинецкий, доктор физико-математических наук, профессор

Газета "Военно-промышленный курьер", опубликовано в выпуске № 14 (777) за 16 апреля 2019 года