Человечество все ближе к созданию полностью автономных боевых машин - роботов. Их задачей будет самостоятельно принимать решение о поражении цели на поле боя. Вокруг таких перспектив ведутся не только технические, но и этические споры. И некоторые берутся утверждать, что боевые роботы не увеличат, а резко уменьшат количество человеческих потерь во время войны. Каким образом?

Би би си сообщает, что вооруженные силы Соединенного Королевства провели самые крупные в своей истории маневры с применением т.н. автономного оружия. Как утверждается, "военные отрабатывали атаки, в которых участвовала живая сила при поддержке дронов и танков с дистанционным управлением".

Строго говоря, "танки с дистанционным управлением" – еще не то самое автономное оружие, снабженное своим собственным интеллектом, позволяющим машине принимать решения самостоятельно, без каких-либо приказов, поступающих с расположенного на удалении от поля боя командного пункта. Но можно считать их промежуточным вариантом, переходной моделью или последним шагом к "умным вооружениям".

В том, что военные устройства смогут вскоре принимать собственные решения без контроля человека, сомнений, кажется, уже ни у кого не осталось. Поэтому и борьба сторонников и противников применения искусственного мозга в вооруженных конфликтах разгорается с каждым днем.

Экспертов, которые говорят, что роботы могут подняться на войну против человечества, мы слышим почти ежедневно. Испанская La Vanguardia пишет, что сегодня, похоже, сбывается предвидение американского режиссера Стэнли Кубрика, высказанное им в пророческом фильме "2001: Космическая одиссея". В картине компьютер HAL 9000 решает атаковать экипаж космического корабля, в котором он установлен, чтобы люди не отключили компьютер.

"Машина, самостоятельно выбирающая цели, которые нужно расстрелять, – это прыжок в неизвестное, чего большая часть человечества, похоже, не хочет понимать. Это обоюдоострая бритва, которая может причинить смертельный ущерб не только объекту, против которого она работает, но и своему создателю и командиру", – отмечают в комментариях для названной выше газеты специалисты в области компьютеризированной робототехники Хоакин Родригес и Розер Мартинес. Они входят в группу экспертов, которая под эгидой ООН готовит почву для разработки будущего международного договора против этого вида оружия.

25 сентября 2018 года свое отношение к происходящему выразил даже генсек ООН Антониу Гутерриш: "Скажу все, как есть. Перспектива создания машин, способных уничтожать человеческие жизни, аморальна и отвратительна". Генсек выступил с опасениями, что технические достижения могут уничтожить человечество так же быстро и так же полно, как ядерное оружие. Для этого вооруженные системы "просто должны выйти из-под контроля человека или попасть в чужие руки". По мнению Гутерриша, "роботы-уничтожители – большая опасность".

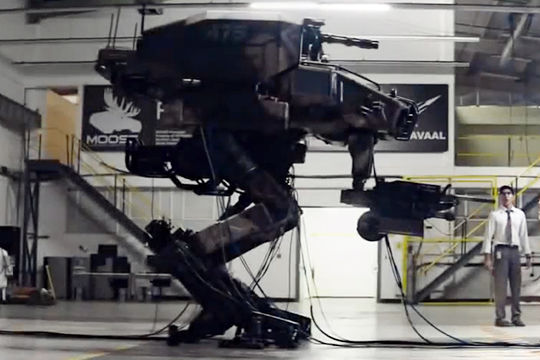

Автономное смертоносное оружие (Lethal Autonomous Weapons, сложившаяся общеупотребительная аббревиатура – LAWs, англ) является результатом исследовательских работ по применению искусственного интеллекта для поиска решений в области военной конфронтации и ведению боевых действий. Известно, что существуют надводные и подводные суда, оборудованные LAWs, а также воздушные и наземные автономные беспилотные летательные аппараты, которые сами выбирают цели. Наземным в некоторых случаях придаются формы, сходные с человеческими.

Закон об автономном оружии: запретить нельзя разрешить

Вокруг предполагаемого закона о запрете разработки, создания и использования самообучающихся роботов в военном деле идут ожесточенные дискуссии специалистов-инженеров. Две основные группы – защитники закона и его противники. Обе постоянно дискутируют по проблемам разнообразного характера, но главным образом сосредоточены на трех темах, связанных с оружием, обладающим искусственным интеллектом: выживание человечества как вида; конфликты этического и морального характера; соответствия или не соответствия данного вида вооружений международному праву и правам человека.

Уже несколько лет существуют автономные системы оружия, в которых вмешательство человеческого фактора в цепочку решений низкое или нулевое. Но до недавнего времени были проверены только защитные системы. Можно вспомнить, что на границе, разделяющей Северную и Южную Кореи, установлены механизмы автоматической стрельбы по всему, что движется по земле. Или, например, так называемый "железный купол" – противоракетную систему Израиля, с помощью которой он должен нейтрализовать снаряды, запущенные из Газы по еврейским позициям. Солдаты, которые контролируют систему, только смотрят, чтобы компьютерная система не дала сбой.

Cui prodest?

Израиль, Франция, Южная Корея, Великобритания, Китайская Народная Республика, Российская Федерация и Соединенные Штаты Америки выступают против любого соглашения планетарного масштаба, которое налагает вето на исследования и разработку оружия с искусственным интеллектом.

Нет необходимости иметь семь пядей во лбу, чтобы определить, почему. Названные страны в настоящий момент – не только лидеры по производству оружия, но главным образом впереди планеты всей по технологическим разработкам. И потому предложения отстающих в этом плане "а давайте все запретим, потому что мы такого сделать не сможем" - не более, чем желание уравнять все страны мира между собой не подтягиваем отсталых, а торможением передовых.

Искусственный интеллект, предсказывают специалисты, в недалеком будущем обретет способность самообучаться. Исходя из этого, многие ученые полагают, что наступит момент, когда робот-убийца станет самостоятельно выбирать цели, посчитав заложенные него человеком задачи и способы их исполнения "неинтересными и неправильными. Робот будет выбирать мишени на свое усмотрение, а оператор потеряет возможность в таком случае воздействовать на процесс принятия машиной решения".

Сложно сказать, нечаянно или намеренно эта группа специалистов "забывает" о том, что всякая кибернетическая машина приводится в действие теми программами, что в нее заложены.

Чтобы робот "сошел с ума" и начал, "гад, во своих пулять", как говорил в "Свадьбе в Малиновке" Попандопуло, может потрудиться враг: для достижения этого эффекта ему нужно проникнуть в компьютерные сети оппонента, найти нужные машины и загрузить в них соответствующий вирус. Для хакеров – не проблема. При соблюдении одного маленького условия (которое никогда не будет реализовано): система, условно говоря, противоракетной обороны должна иметь выход в интернет. Чтобы, значит, прямо из "Фейсбука" или с помощью реплики Трампа в "Твиттере"…

Вот такой парадокс

Конечно, с мнением Гуттериша насчет аморальности и отвратительности создания машин, способных уничтожать человеческие жизни, нельзя не согласиться. Но если подумать: изобретение оружия вообще – штука не слишком моральная. Каждая винтовка, автомат, система залпового огня и атомная бомба, в конце концов, изначально задумываются как инструмент убийства. И в этом смысле, рассматривая идею автономного оружия с этой точки зрения, приходишь к парадоксальному выводу. Принятие на вооружение таких установок дает возможность уменьшить человеческие потери - даже при обычной перестрелке.

Сторонники LAW (Lethal Autonomous Weapons) уверены, что применение этих систем уменьшит число человеческих жертв во время войн. Потому что роботам неведом страх, они не реагируют на истерию, раскручиваемую вокруг них, и у них не возникает желания отомстить.

Но дело еще и в том, что за пулеметом или зениткой при таком раскладе человеку стоять (лежать) не приходится, а значит, уменьшается риск потери людей.

Машины будут уничтожать другие машины - а не живых существ. Разве это – не благая цель?

Владимир Добрынин